环境搭建概览

一个完整的AI开发环境包含多个关键组件,从Python环境管理到GPU加速,每一步都至关重要

Python环境管理

使用Anaconda或Miniconda创建隔离的Python环境,确保项目间的依赖不冲突

AI核心库安装

安装NumPy、Pandas、Scikit-learn等基础数据科学库

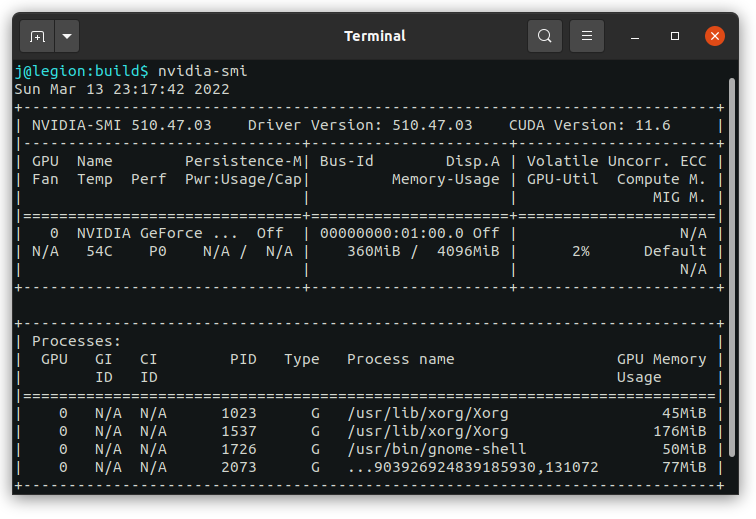

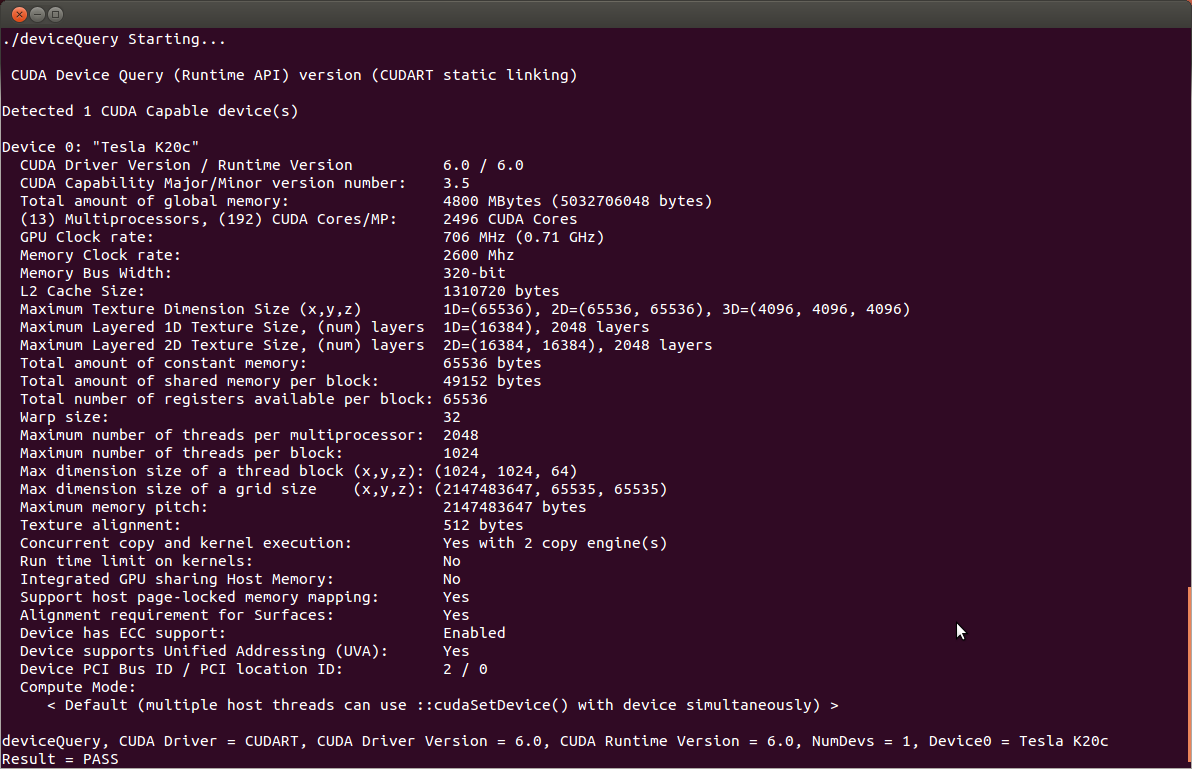

GPU环境配置

配置NVIDIA CUDA和cuDNN,实现深度学习模型的GPU加速

NVIDIA驱动安装

版本450.80.02或更高

CUDA Toolkit

推荐版本11.8

cuDNN配置

版本8.6.0

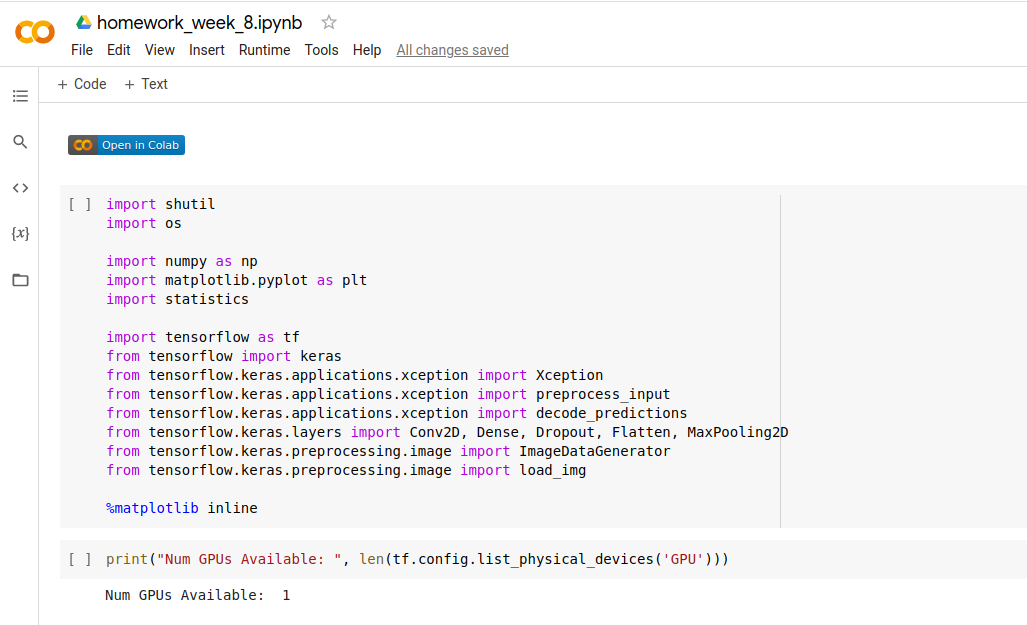

云平台使用

Google Colab和Kaggle Kernels的GPU加速配置